对自动驾驶来说,多传感器融合感知一直是个难题。蘑菇车联与清华大学猛狮团队组成研究组,构建了融合感知框架InterFusion,能够更好地结合4D毫米波雷达和激光雷达优势,更准确地感知周围环境。测试结果显示,InterFusion的表现要明显优于多个主流感知算法。此项研究成果被IROS 2022收录为大会论文。

IROS 2022大会现场

IROS 2022大会现场IROS、ICRA和ROBIO一并被业界公认为人工智能领域最具影响力的国际学术会议,蘑菇车联今年的研究成果已被其中两个会议收录。今年IROS共收到3579投稿,其中的1716篇被接收,接收率为47.9%。此前,蘑菇车联与清华联手打造的路侧数据集被ICRA 2022收录。

激光雷达、毫米波雷达是自动驾驶车辆中常见的传感器,二者分别通过发射激光束和毫米波来感知外部环境。激光雷达能够提供3D感知数据,但其点云数据会受到距离影响,距离越远越稀疏,在恶劣天气下进一步恶化,穿透力强的毫米波雷达正好可以弥补这一缺点。

目前,4D毫米波雷达逐步进入市场,激光雷达与4D毫米波雷达的融合也受到更多关注。不过,现阶段行业内大多数方案都无法实现两种模态的相互作用,这不利于感知数据的最佳应用。

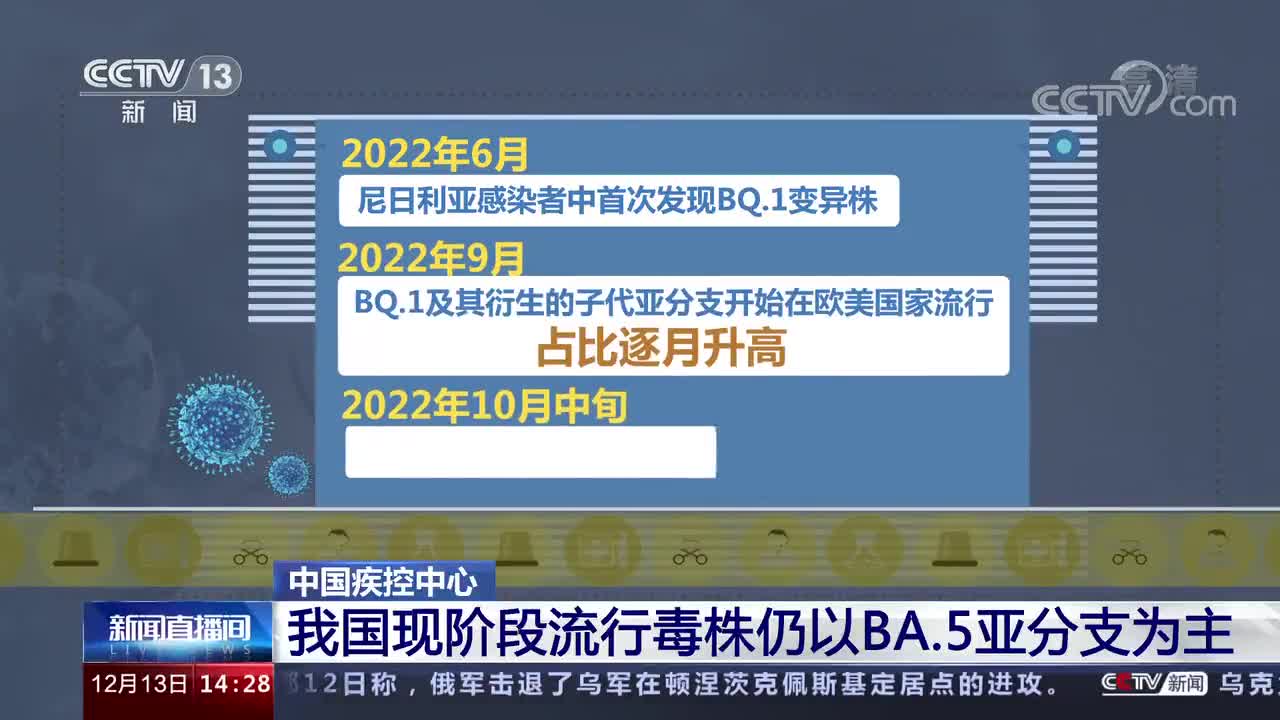

鉴于此,蘑菇车联、清华的研究团队提出一种低成本的融合感知框架InterFusion,能够更好地发挥激光雷达、4D毫米波雷达各自优势。InterFusion包含有数据预处理方法,能够消除4D毫米波雷达点云角度偏移误差;受自注意力机制(Self-attention Mechanism)启发,InterFusion框架聚合了来自两种模态的特征,并有效地识别了4D毫米波雷达和16线激光雷达特征之间的跨模态关系。在Astyx HiRes 2019数据集的实验评估中,InterFusion融合感知框架在3D mAP中表现优于基线4.20% ,在BEV mAP中表现优于基线10.76%。

从上到下数据来源依次为:相机,参照用真实数据,4D毫米波雷达,激光雷达,采用InterFusion融合架构的4D毫米波雷达+激光雷达

在上图中,蓝色点代表激光雷达点云,黄色点代表4D毫米波雷达点云,第一行是来自相机的原始图像;第二行为作参照的、符合实际情况的真实数据;第三行的4D毫米波雷达点云稀疏,存在误检和漏检;第四行激光雷达点云在长距离时变得稀疏,这意味着其对远程对象的一些误检或漏检。最后一行则是采用了InterFusion融合感知架构生成的激光雷达、4D毫米波雷达点云感知结果,可以看到其感知结果要优于第三、四行的单模态方法,十分接近第二行的真实数据。

InterFusion融合感知框架能够有效提升自动驾驶安全性。车辆只有准确识别环境,才能做出更安全、更合理的规划与决策。

作为“车路云一体化”方案的先行者和践行者,蘑菇车联积极探索自动驾驶前沿技术,公司与清华大学的多项研究成果有效提高蘑菇车联“车路云一体化”系统的安全性、可靠性,为大规模应用提供有力支撑。

蘑菇自动驾驶汽车大脑

蘑菇车联自动驾驶清扫车

蘑菇车联“车路云一体化”技术方案示意

蘑菇车联“车路云一体化”技术方案示意(来源:新视线)